“我真的厌恶了看到那些急于求成的科技草创公司,为了巴结风投而在数据上说谎,还贴上‘SOTA’的标签。”有网友吐槽。

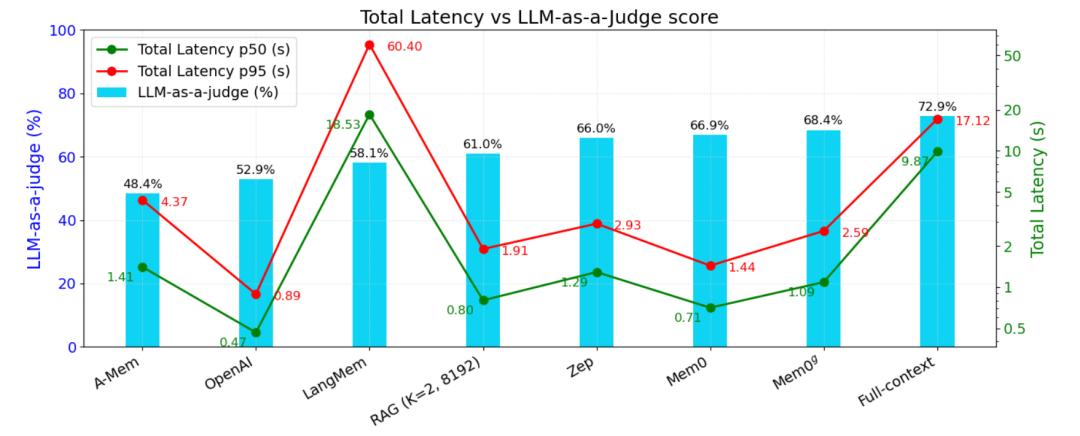

工作源于高人气开源智能体回忆项目 Mem0 在本年 4 月底发布的一篇论文。论文中,该项目团队为可扩展的、以回忆为中心的架构 Mem0 提出了增强版别,并宣称在 LOCOMO 上打败了所有人,其间,Mem0 在 “LLM-as-a-Judge” 方针上相较于 OpenAI 提高了 26%。(论文地址:https://arxiv.org/abs/2504.19413)

当地时刻 8 月 13 日, 另一个高人气的智能体回忆结构 MemGPT 的开创团队 Letta AI ,其联合开创人兼 CTO Sarah Wooders 对此揭露指控:

几个月前,Mem0 发布了 MemGPT 的基准测验数据,并宣称在回忆方面达到了 “SOTA” 水平。

奇怪的是,我彻底不知道他们到底是怎样跑这个基准测验的,假如不对 MemGPT 做严重修正,这个测验底子无法完结(他们没有回应咱们关于试验详细运转办法的问询)。

arXiv 并不是经过同行评定的渠道,所以不幸的是,近年来公司能够随意发布任何他们想要的“研讨”成果来做市场营销。

咱们很轻松就用一些简略的文件体系东西逾越了他们的基准数据——这也阐明这个基准测验自身并没有太大含义。

“Mem0 宣称他们在 LOCOMO 上打败了所有人,但成果发现他们彻底把竞争对手的完结搞砸了。然后还用这些糟糕的成果来证明自己的优势。比及 Letta 和 Zep 按正确办法跑了基准测验后,两者的得分都比 Mem0 的最佳成果高出 10%。”网友点评道,“这个职业里的‘空气产品’多到离谱。我了解为了拿到风投,企业会夸张功用,但在科研论文里说谎实在是可悲。”

两个“顶流”兴起

Mem0 和 Letta 的诞生都是为了处理大模型的长时刻回忆问题。

自 GPT-4 面世以来,大模型一向受限于固定的上下文长度。没有长时刻回忆,大模型和智能领会面对显着约束:它们会忘记信息,无法跟着时刻学习和改善,而且在长时刻、杂乱的使命中会失掉方针。

为此,在 2023 年,加州大学伯克利分校(UC Berkeley)的研讨团队提出的一种创新式体系 MemGPT, 学习传统操作体系(OS)的理念,引进了智能体的回忆办理,经过构建回忆层级,让智能体主动办理哪些信息保留在即时上下文(中心回忆)中、哪些存储在外部层(对话回忆、归档回忆和外部文件),以便按需检索。这样,智能体能够在固定的上下文窗口内坚持无限的回忆容量。

MemGPT 的研讨敏捷引起社区重视,MemGPT 论文的帖子在 Hacker News 主页上停留了 48 小时,开源后已累积 17.8k stars。

跟着开源项目的推进,团队建立了名为 Letta 的公司,继续保护 MemGPT 开源结构,并推进其商业化和工程化落地。本来的 MemGPT 也晋级成了 Letta。

这家由伯克利博士生 Sarah Wooders 和 Charles Packer 创立的 AI 草创公司备受等待。Letta 取得了由 Felicis 的 Astasia Myers 领投的 1000 万美元种子资金,本轮估值为 7000 万美元。此外,还得到了人工智能范畴一系列天使投资人的支撑,其间包含谷歌的 Jeff Dean、Hugging Face 的 Clem Delangue、Runway 的 Cristóbal Valenzuela 和 Anyscale 的 Robert Nishihara 等。

现在,许多智能体体系都完结了 MemGPT 的规划。

Mem0 则是由印度工程师 Taranjeet Singh 和 Deshraj Yadav 建立,源于他们构建开源检索增强生成 (RAG) 结构 Embedchain 的经历,该结构下载量逾越 200 万次。

依据 YC 的介绍,Singh 曾作为首位增加工程师参加 Khatabook(YC S18),并敏捷晋升为高档产品司理。他的软件工程职业生涯始于 Paytm(印度的 PayPal),亲历了其敏捷兴起成为众所周知的品牌。他开发了一款由 AI 驱动的教导运用,曾在 Google I/O 上露脸。他与 Deshraj 一起创立了 EvalAI,这是一个开源的 Kaggle 代替渠道,GitHub 上取得了 1.6K stars。他还创立了首个 GPT 运用商铺,用户规划打破 100 万。

Yadav 则广泛重视人工智能和机器学习基础设施范畴,曾领导特斯拉主动驾驭的 AI 渠道,呐喊tణ辉煌岁月txt全集下载0;武至尊txt全集下载xt免费下载支撑特斯拉全主动驾驭开发中的大规划练习、模型评价、监控和可观测性。在此之前,Deshraj 在乔治亚理工学院完结硕士论文时创立了开源机器学习渠道 EvalAI,并在 CVPR、ECCV、AAAI 等上宣布过论文。

Mem0 以为,单纯地扩展模型的上下文窗口只会推迟问题的产生,模型会变得更慢、本钱更高,而且仍然会疏忽要害细节。团队挑选经过一个通用、可扩展的回忆架构来处理问题,Mem0 充当了 AI 运用程序和大模型之间的回忆层,能够动态地从用户对话中提取、整合和检索重要信息。

Mem0 供给轻量级的回忆层 API 和向量检索,开源不到一天就取得了 9.7k stars,现在已累积 38.2k stars。Netflix、Lemonade 和 Rocket Money 等安排已选用 Mem0 来增强其 AI 体系的长时刻回忆才能。

此外,业界还呈现了多种专用东西,将“回忆”作为可插拔的服务,为智能体供给存储与检索信息的才能,常见办法包含运用常识图谱或向量数据库等计划。

独自评价这些回忆东西的有用性极端困难。智能体的回忆质量往往更多取决于底层智能体体系办理上下文和调用东西的才能,而不是回忆东西自身。比方,即使一个查找东西理论上功用更强,但假如智能体无法有用运用它,例如提示词规划差或练习数据中短少相关示例,它在回忆场景下的体现也不会好。

因而,回忆东西的评价首要会集在类似 LoCoMo 这样的检索基准测验,而非真实的智能体回忆才能。

LoCoMo 是一个从长对话中进行检索的问答基准,专门用于评价大模型长时刻对话回忆才能,由 Snap Research 团队推出。每个样本包含两名虚拟说话者和一份 AI 生成的带时刻戳的对话记载,使命是答复关于说话者或对话中呈现的现实问题。

不合在哪里?

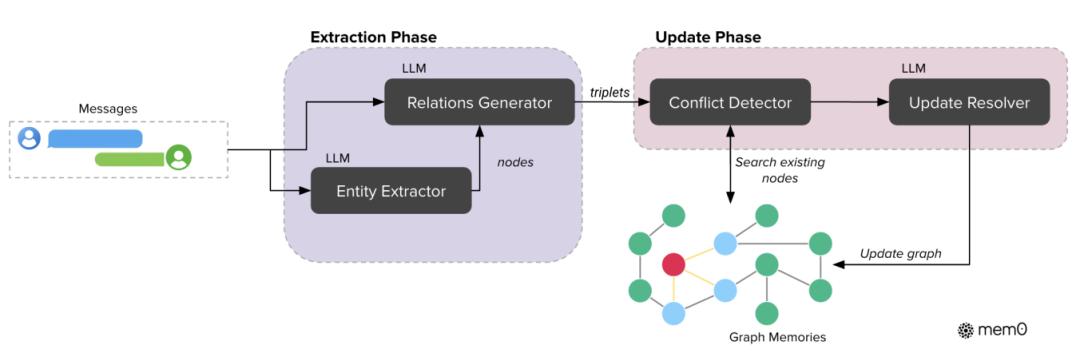

在 4 月底的论文中,Mem0 团队在之前的基础上引进了依据图的回忆表明,来增强联系建模才能。

之前,Mem0 的提取阶段处理音讯和前史上下文以创立新的回忆;更新阶段则将提取出的回忆与类似的现有回忆进行比对,经过东西调用机制履行相应操作。数据库作为中心存储库,供给处理所需的上下文,并存储更新后的回忆。

引进依据图的回忆后,提取阶段运用大模型将对话音讯转换为实体和联系三元组;更新阶段在将新信息整合到已有常识图谱时,选用抵触检测与处理机制。

在实践完结中,Mem0g 运用 Neo4j 作为底层图数据库 ,依据大模型的提取器和更新模块并凭借具有函数调用才能的 GPT-4o-mini,从非结构化文本中进行结构化信息提取。经过将依据图的表明与语义嵌入以及依据大模型的信息提取相结合,Mem0 取得了杂乱推理所需的结构丰厚性和自然语言了解所需的语义灵敏性。

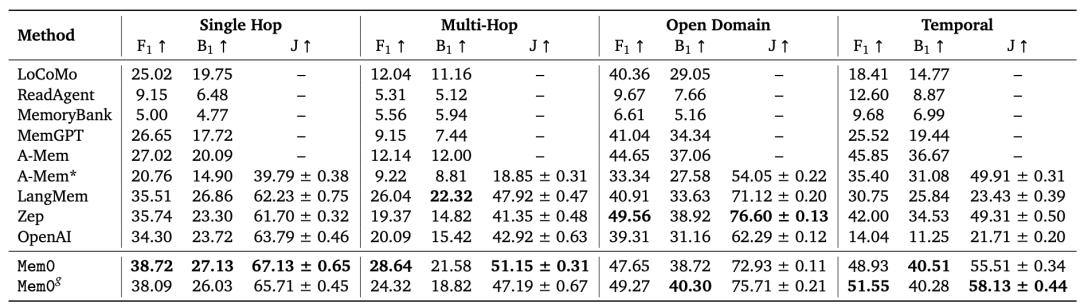

在 LOCOMO 基准测验中,Mem0 表明其继续逾越六种抢先的回忆办法,体现为:呼应准确率比 OpenAI 的提高 26% 、推迟比全上下文办法下降 91%、token 运用量节约 90%。

下图是不同回忆办法在 p50 和 p95 的总呼应推迟比较,其间包含了大模型推理在内的推迟。

Mem0 团队以为,在 AI 智能体布置中,依据详细推理场景灵敏调整回忆结构很重要:

Mem0 的稠密回忆管道拿手快速呼应、简略查询,最大极限削减 token 耗费与核算开支;而改善后,Mem0 的结构化图表征能明晰解析杂乱联系,支撑杂乱事情排序和丰厚上下文整合,一起不献身实践功率。两者合力构建了一个多功用的回忆东西包,能够习惯多样的对话需求,并具有大规划布置才能。

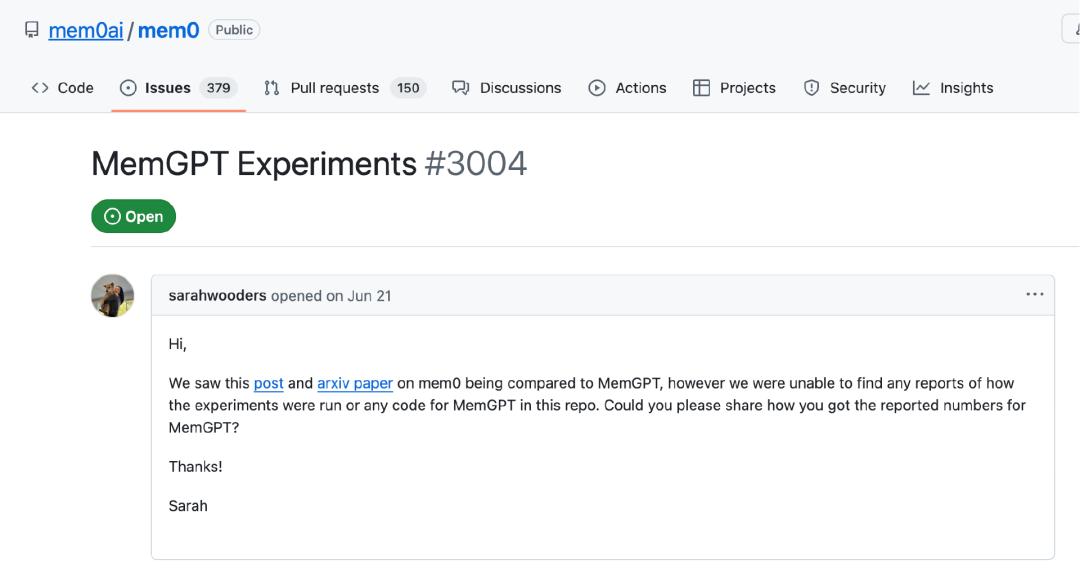

6 月时分,Sarah 在 GitHub 上问询 Mem0 是怎么取得 MemGPT 的相关数据的,但没有回应。

“有一个回忆东西厂商 Mem0 发布了有争议的成果,宣称在 LoCoMo 上运转了 MemGPT。但成果令人困惑,因为咱们(MemGPT 的原团队)无法找到不进行大规划代码重构就将 LoCoMo 数据灌入 MemGPT/Letta 的办法。Mem0 并呐喊txt免$辉煌岁月txt全集下载153;下载未回应咱们对其基准测验核算办法的弄清恳求,神武至尊txt全集下载也没有供给支撑 LoCoMo 数据回填的修正版 MemGPT 完结。”Letta 表明。

当地时刻 8 月 12 日,Letta 发文称,Letta 在 LoCoMo 上仅经过将对话前史存储在文件中(而不是运用专门的回忆或检索东西),就达到了 74.0% 的准确率。这表明:

之前的回忆基准测验或许并不十分有含义;

回忆更多取决于智能体怎么办理上下文,而不是所运用的详细检索机制。

Letta 表明,尽管 Letta 自身没有原生办法导入 LoCoMo 那样的对话前史,但其最近为 Letta 智能体(包含 MemGPT 智能体)增加了文件体系功用。“咱们猎奇,假如仅仅把 LoCoMo 的对话前史放进一个文件,而不运用任何专用回忆东西,Letta 的体现会怎么。”

当文件被挂载到 Letta 智能体后,智能体能够运用以下文件操作东西:

- grep

- search_files

- open

- close

对话数据被放进一个文件并上传挂载到智能体中。Letta 会主动解析并嵌入文件内容,以便进行语义(向量)查找。智能体能够用 search_files 做语义查找,用 grep 进行文本匹配,再用 answer_question 答复问题。

为了与 MemGPT 的原试验坚持一致,Letta 用 GPT-4o mini 作为模型。因为 GPT-4o mini 才能较弱,Letta 让智能体部分自治,经过规矩约束其调用东西的形式:必须先调用 search_files 查找文件,再不断查找直到决议调用 answer_question 并完毕。查找什么、查找多少次由智能体自行决议。

“这个简略的智能体在 GPT-4o mini 和最少提示调优的情况下,就在 LoCoMo 上取得了 74.0% 的成果,显着高于 Mem0 陈述的其最佳图回忆版别的 68.5%。”

Letta:才能比东西更重要

Letta 以为,现在的智能体在运用东西方面十分高效,尤其是那些很或许呈现在练习数据中的东西,如文件体系操作。因而,许多本来为单跳检索规划的专用回忆东西,还不如直接让智能体自主迭代查找数据来得有用。

智能体能够生成自己的查找查询,而不仅仅是检索原始问题,例如将 “How does Calvin stay motivated when faced with setbacks?” 转化为 “Calvin motivation setbacks”,而且智能体能够继续查找直到找到正确数据。

智能体是否“记住”了某事,取决于它能否在需求时成功检索到正确信息。因而,更重要的是考虑智能体是否能够有用运用检索东西(知道何时以及怎么调用),而不是纠结于详细的检索机制(如常识图谱仍是向量数据库)。

Letta 还提出,现在智能体能够十分高效地运用文件体系东西,在很大程度上是因为后期优化要点倾向智能体的编码使命。一般来说,越简略的东西越或许呈现在智能体的练习数据中,也越简略被有用运用。尽管更杂乱的计划(如常识图谱)在特定范畴或许有用,但它们或许更难被 大模型(智能体)了解。

“智能体的回忆才能取决于智能体的架构、东西和底层模型。比较智能体结构与回忆东西,就像比较苹果和橘子,因为结构、东西和模型都是能够自由组合的。”Letta 说道。

那怎么正确评价智能体回忆才能呢?

Letta 先引荐了自家的 Letta Memory Benchmark(Letta 排行榜) 供给了同类比照(apples-to-apples),在坚持结构(现在仅 Letta)和东西不变的情况下,评价不同模型在回忆办理方面的才能。该基准在动态上下文中即时生成回忆交互场景,然后评价智能体回忆,而不仅仅是检索才能(如 LoCoMo)。

然后指出,另一种办法是直接评价智能体在需求回忆的详细使命中的全体体现。例如 Terminal-Bench,测验智能体处理杂乱、长时刻运转使命的才能。因为使命时刻长且需求处理远超上下文窗口的信息,智能体能够运用回忆盯梢使命状况与进展。

最终,Letta 总结道,关于规划杰出的智能体,即使是简略的文件体系东西,也足以在 LoCoMo 这样的检索基准中体现优异。

参阅链接:

https://x.com/sarahwooders/status/1955352237490008570?s=46

https://www.letta.com/blog/benchmarking-ai-agent-memory

本文来自微信大众号“InfoQ”,作者:褚杏娟 ,36氪经授权发布。